In der digitalisierten Welt gewinnt die Langzeitarchivierung von digitalen Inhalten immer mehr an Bedeutung. Zum Welttag der digitalen Erhaltung bzw. World Digital Preservation Day wollen wir deshalb auf einen eher unscheinbaren, aber wichtigen Aspekt der digitalen Langzeitarchivierung (LZA) eingehen: den Umgang mit fehlerhaften Dateien in unserem Langzeitarchivierungssystem.

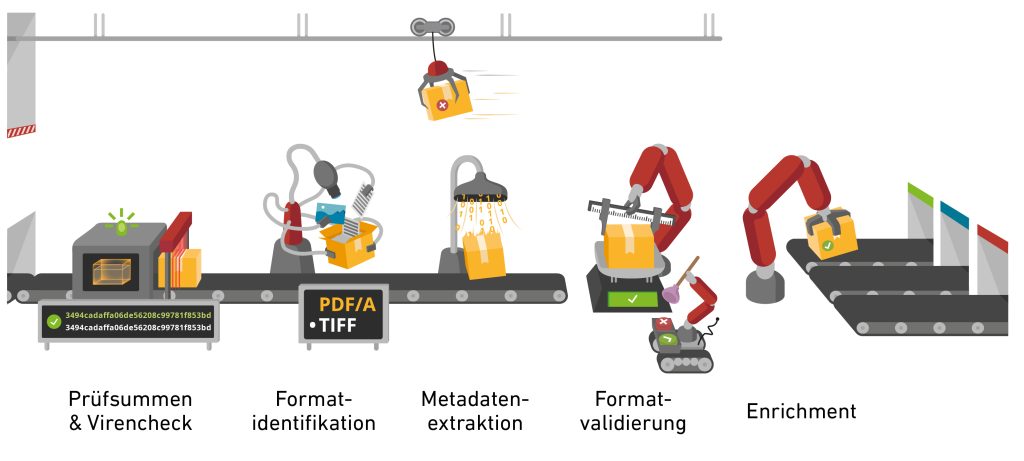

In der ETH-Bibliothek nutzen wir das Langzeitarchivierungssystem Rosetta der Firma Ex Libris. Alle Dateien durchlaufen während des Imports – im LZA-Jargon «Ingest» – ins System verschiedene Prozesse, die sicherstellen sollen, dass die Dateien in ferner Zukunft noch nachgenutzt werden können. Dazu gehört die Gewährleistung der Datenintegrität mithilfe eines Prüfsummenchecks, ein Virenscan sowie die Identifikation des Dateiformats und, wenn möglich, auch die Validierung, also Sicherstellung, dass die Datei der Formatspezifikation entspricht. Von zentraler Bedeutung ist die Extraktion technischer Metadaten, welche für die Validierung grundlegend ist, aber auch künftig bei der Identifikation aktuell noch nicht bekannter Risiken helfen könnte.

Analyse problematischer Dateien – es gibt keine allgemeingültige Regel

Wird während des Imports ein Problem mit einer Datei festgestellt, wird diese vorerst nicht archiviert, sondern in die sogenannte Technical Analyst Workbench weitergeleitet. Dort kann die Fehlermeldung begutachtet und die Datei heruntergeladen und analysiert werden. Je nach Ergebnis erfolgt eine Kategorisierung des Problems nach Schweregrad und entsprechende Massnahmen werden ergriffen. Im einfachsten Fall handelt es sich um einen als harmlos eingeschätzten Fehler, den wir ignorieren können. Wenn es schwerwiegende Fehler sind, versuchen wir, die Dateien zu reparieren oder müssen sie, je nach Fehlerart, ablehnen, denn in der Regel ist es für die Datenproduzenten einfacher, Probleme zu beheben. Falls systematische Fehler aus einer Quelle beobachtet werden, müssen diese in jedem Fall mit der produzierenden Stelle geklärt werden.

Der Arbeitsablauf scheint zeitaufwändig und für regelmässig wiederkehrende, als unproblematisch bewertete Fehler stellt sich die Frage nach Regeln, welche die Fehlermeldung ignorieren und die Datei ohne Umweg über den Technical Analyst ins Archiv leiten. Tatsächlich erstellen wir für harmlose Fehlermeldungen solche Regeln, die jeweils für ein Dateiformat und einen Datenproduzenten spezifisch sind. Da wir aber die Kontrolle darüber behalten möchten, ob ein bestimmter Fehler regelmässig auftritt oder an der Quelle behoben wird, sind wir zurückhaltend im Erstellen von Regeln. In manchen Fällen ist es auch nicht möglich, eine Regel zu erstellen: wenn die Fehlermeldung spezifische, sich auf die Datei beziehende Teile (z.B. Referenzen) besitzt. Es gibt auch Sonderfälle, bei denen der Validator jeweils nur den ersten Fehler findet und danach die Validierung stoppt. Würde die entsprechende Fehlermeldung ignoriert, könnten unentdeckte Probleme ungewollt ins Langzeitarchivsystem gelangen. Das führt dazu, dass obwohl wir bereits viele Regeln im Einsatz haben, Fehlermeldungen regelmässig geprüft und Dateien analysiert werden müssen.

Validation Stack in Rosetta: gibt es bei einem dieser Schritte während des Importvorgangs ein Problem, landet die Datei im Technical Analyst (TA). (Illustration: Andres Bucher)

Von harmlosen Fehlern via passwortgeschützten zu korrupten Dateien

Wie wird im Falle einer Fehlermeldung konkret vorgegangen? Wenn wir eine Datei analysieren, dokumentieren wir die Fehlermeldungen und Handlungsanweisung ausserhalb von Rosetta. Bei jeder neuen Fehlermeldung können wir somit prüfen, ob die Meldung schon bekannt ist und wie in früheren Fällen entschieden wurde, also ob der Fehler ignoriert oder die Datei korrigiert werden soll.

Bei den meisten Fehlermeldungen handelt es sich glücklicherweise um harmlose Verstösse gegen die Spezifikation, die nicht als Risiko für die Langzeitarchivierung betrachtet werden, zum Beispiel falsch formatierte Datumsangaben. Diese Dateien werden entweder manuell oder automatisiert per Regel ins Archivsystem weitergeleitet. Schwerwiegende, risikobehaftete Fehler in den technischen Metadaten, zum Beispiel ein falscher Offset oder die Verwendung einer unerwünschten Komprimierung können oft durch das Neuschreiben der Metadaten bzw. durch das Neuspeichern der Datei behoben werden. Dabei werden die Metadaten in Übereinstimmung mit der Spezifikation neu geschrieben bzw. es wird eine neue Datei ohne Komprimierung abgespeichert, womit das Problem behoben werden kann. Dateien, die aufgrund eines Passwortschutzes oder wegen eines technischen Problems nicht geöffnet werden können, werden an den Datenproduzenten retourniert.

Für die Einspielung ins Langzeitarchivierungssystem sind viele Schritte notwendig

Alle analysierten Dateien und Regeln werden in einer separaten Excel-Datei festgehalten. Diese Datei wird ebenfalls regelmässig archiviert. Wir archivieren also nicht nur die Dateien, die wir erhalten, sondern auch jene, die Informationen zu unserem eigenen Vorgehen enthalten. So stellen wir sicher, dass in Zukunft nachvollziehbar ist, weshalb wir gewisse Entscheidung getroffen haben und wie wir vorgegangen sind.

In die Analyse von fehlerhaften Dateien sind jeweils mehrere Personen involviert. Dies zeigt, dass nicht alles automatisiert erfolgen kann und der Import von Dateien ins Langzeitarchivierungssystem nicht so trivial ist, wie es auf den ersten Blick erscheint. Stetige Verbesserungen am System und an den verwendeten Tools erleichtern und reduzieren die Arbeit. Das führt dazu, dass die meisten Dateien unterdessen problemlos ins Archiv überführt werden können. Insbesondere dann, wenn mit den Datenproduzenten abgesprochen werden kann, was in welcher Form archiviert werden soll. Es ist aber gerade bei sehr heterogenen Datenablieferungen nicht immer möglich, einen ausgeklügelten Arbeitsprozess aufzustellen. In diesen Fällen bleibt der Aufwand der manuellen Datenüberprüfung und -validierung bestehen.

Das ETH Data Archive hat sich schon einmal in KiK vorgestellt. Siehe den ganzen Artikel hier: https://kik.ethbib.ethz.ch/magazin/das-eth-data-archive-stellt-sich-vor/

Schreibe einen Kommentar